文章目录

- 1. 样本期望和方差

- 2. Markov 不等式&Chebyshev不等式

- 2.1 Markov不等式公式 概述

- 2.2 Markov不等式公式 证明:

- 2.3 Markov不等式公式 举例:

- 2.4 Chebyshev不等式公式概述:

- 2.5 Chebyshev不等式公式证明:

- 3. 协方差矩阵

- 3.1 举例

- 3.2 Python 代码

1. 样本期望和方差

1.1 样本期望 E ( X ) \mathrm{E}(X) E(X)

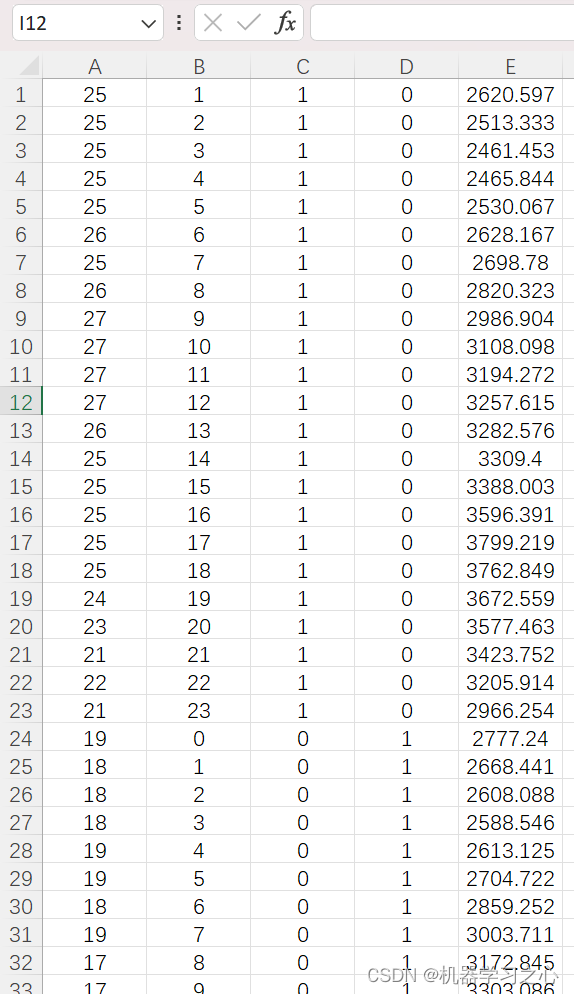

假设我们有N个样本及概率如下

x

1

→

p

1

,

x

2

→

p

2

,

⋯

,

x

n

→

p

n

x_1\rightarrow p_1,x_2\rightarrow p_2,\cdots,x_n\rightarrow p_n

x1→p1,x2→p2,⋯,xn→pn,那么样本期望

E

(

X

)

E(X)

E(X)

E

(

X

)

=

m

=

∑

i

=

1

N

p

i

x

i

\begin{equation} \mathrm{E}(X)=m=\sum_{i=1}^Np_ix_i \end{equation}

E(X)=m=i=1∑Npixi

- 函数期望:

E ( f ( x ) ) = m = ∑ i = 1 N p i f ( x i ) \begin{equation} \mathrm{E}(f(x))=m=\sum_{i=1}^Np_if(x_i) \end{equation} E(f(x))=m=i=1∑Npif(xi)

1.2 样本期望 D ( X ) \mathrm{D}(X) D(X)

D ( X ) = σ 2 = E [ ( x i − m ) 2 ] \begin{equation} \mathrm{D}(X)=\sigma^2=\mathrm{E}[(x_i-m)^2] \end{equation} D(X)=σ2=E[(xi−m)2]

- 展开可得:

D ( X ) = ∑ i = 1 N p i ( x i − m ) 2 \begin{equation} \mathrm{D}(X)=\sum_{i=1}^Np_i(x_i-m)^2 \end{equation} D(X)=i=1∑Npi(xi−m)2 - 展开可得:

= p 1 ( x 1 2 + m 2 − 2 x 1 m ) + p 2 ( x 2 2 + m 2 − 2 x 2 m ) + ⋯ + p n ( x n 2 + m 2 − 2 x n m ) \begin{equation} =p_1(x_1^2+m^2-2x_1m)+p_2(x_2^2+m^2-2x_2m)+\cdots+p_n(x_n^2+m^2-2x_nm) \end{equation} =p1(x12+m2−2x1m)+p2(x22+m2−2x2m)+⋯+pn(xn2+m2−2xnm)

= p 1 ( x 1 2 + x 2 2 + ⋯ + x n 2 ) + ( p 1 + p 2 + ⋯ + p n ) m 2 − 2 m ( p 1 x 1 + p 2 x 2 + ⋯ + p n x n ) \begin{equation} =p_1(x_1^2+x_2^2+\cdots+x_n^2)+(p_1+p_2+\cdots+p_n)m^2-2m(p_1x_1+p_2x_2+\cdots+p_nx_n) \end{equation} =p1(x12+x22+⋯+xn2)+(p1+p2+⋯+pn)m2−2m(p1x1+p2x2+⋯+pnxn) - 因为 p 1 + p 2 + ⋯ + p n = 1 , p 1 x 1 + p 2 x 2 + ⋯ + p n x n = m p_1+p_2+\cdots+p_n=1,p_1x_1+p_2x_2+\cdots+p_nx_n=m p1+p2+⋯+pn=1,p1x1+p2x2+⋯+pnxn=m

- E ( X 2 ) = p 1 ( x 1 2 + x 2 2 + ⋯ + x n 2 ) , E ( X ) = m = ∑ i = 1 N p i x i \mathrm{E}(X^2)=p_1(x_1^2+x_2^2+\cdots+x_n^2),\mathrm{E}(X)=m=\sum_{i=1}^Np_ix_i E(X2)=p1(x12+x22+⋯+xn2),E(X)=m=∑i=1Npixi

- 整理可得:

D ( X ) = E ( X 2 ) + m 2 − 2 m 2 = E ( X 2 ) − [ E ( X ) ] 2 \begin{equation} D(X)=\mathrm{E}(X^2)+m^2-2m^2=\mathrm{E}(X^2)-[\mathrm{E}(X)]^2 \end{equation} D(X)=E(X2)+m2−2m2=E(X2)−[E(X)]2

2. Markov 不等式&Chebyshev不等式

2.1 Markov不等式公式 概述

假设X是一个均值有限的非负随机变量,均值为

E

(

X

)

\mathrm{E}(X)

E(X),这意味着

P

(

X

<

0

)

=

0

P(X<0)=0

P(X<0)=0,那么对于任意的正数a,有

P

r

o

b

(

X

≥

a

)

≤

E

(

X

)

a

,

X

i

≥

0

\begin{equation} Prob(X\ge a)\le\frac{\mathrm{E}(X)}{a},X_i\ge 0 \end{equation}

Prob(X≥a)≤aE(X),Xi≥0

- 同等公式如下:

P r o b ( X < a ) ≥ 1 − E ( X ) a \begin{equation} Prob(X< a)\ge 1-\frac{\mathrm{E}(X)}{a} \end{equation} Prob(X<a)≥1−aE(X)

2.2 Markov不等式公式 证明:

我们定义样本分布的概率密度为

f

(

x

)

f(x)

f(x),如下图所述:

- 我们可以得到期望E(X)表示如下:

E ( X ) = ∫ 0 ∞ x f ( x ) d x \begin{equation} \mathrm{E}(X)=\int_{0}^{\infty}xf(x)\mathrm{d}x \end{equation} E(X)=∫0∞xf(x)dx - 因为 x , f(x)我们定义均大于等于0,所以可以进行缩放,将原来积分从0到正无穷缩小到a到正无穷

∫ 0 ∞ x f ( x ) d x ≥ ∫ a ∞ x f ( x ) d x \begin{equation} \int_{0}^{\infty}xf(x)\mathrm{d}x\ge\int_{a}^{\infty}xf(x)\mathrm{d}x \end{equation} ∫0∞xf(x)dx≥∫a∞xf(x)dx - 因为每个x现在都大于等于a,

x

≥

a

x\ge a

x≥a,所以可以将系数x缩放为a,即:

∫ 0 ∞ x f ( x ) d x ≥ ∫ a ∞ x f ( x ) d x ≥ ∫ a ∞ a f ( x ) d x = a ∫ a ∞ f ( x ) d x \begin{equation} \int_{0}^{\infty}xf(x)\mathrm{d}x\ge\int_{a}^{\infty}xf(x)\mathrm{d}x\ge\int_{a}^{\infty}af(x)\mathrm{d}x=a\int_{a}^{\infty}f(x)\mathrm{d}x \end{equation} ∫0∞xf(x)dx≥∫a∞xf(x)dx≥∫a∞af(x)dx=a∫a∞f(x)dx - 这里的

∫

a

∞

f

(

x

)

d

x

=

P

(

X

≥

a

)

\int_{a}^{\infty}f(x)\mathrm{d}x=P(X\ge a)

∫a∞f(x)dx=P(X≥a),则整理上面公式可得:

E ( X ) ≥ a P ( X ≥ a ) → P ( X ≥ a ) ≤ E ( X ) a \begin{equation} \mathrm{E}(X)\ge a P(X\ge a)\rightarrow P(X\ge a)\le \frac{\mathrm{E}(X)}{a} \end{equation} E(X)≥aP(X≥a)→P(X≥a)≤aE(X) - 综上所述,我们得到马尔科夫不等式如下:

P ( X ≥ a ) ≤ E ( X ) a \begin{equation} P(X\ge a)\le \frac{\mathrm{E}(X)}{a} \end{equation} P(X≥a)≤aE(X) - 假设样本和概率表示如下:

| Sample | x 1 = 1 x_1=1 x1=1 | x 2 = 2 x_2=2 x2=2 | x 3 = 3 x_3=3 x3=3 | x 4 = 4 x_4=4 x4=4 | x 5 = 5 x_5=5 x5=5 |

|---|---|---|---|---|---|

| P | p 1 p_1 p1 | p 2 p_2 p2 | p 3 p_3 p3 | p 4 p_4 p4 | p 5 p_5 p5 |

E ( X ) = p 1 x 1 + p 2 x 2 + p 3 x 3 + p 4 x 4 + p 5 x 5 \begin{equation} \mathrm{E}(X)=p_1x_1+p_2x_2+p_3x_3+p_4x_4+p_5x_5 \end{equation} E(X)=p1x1+p2x2+p3x3+p4x4+p5x5

- 我们假设期望为1 ,

E

(

X

)

=

1

\mathrm{E}(X)=1

E(X)=1

- E ( X ) = p 1 x 1 + p 2 x 2 + p 3 x 3 + p 4 x 4 + p 5 x 5 = 1 \begin{equation} \mathrm{E}(X)=p_1x_1+p_2x_2+p_3x_3+p_4x_4+p_5x_5=1 \end{equation} E(X)=p1x1+p2x2+p3x3+p4x4+p5x5=1 - X>3的概率如下:

P r o b ( X ≥ 3 ) ≤ E ( X ) 3 → P r o b ( X ≥ 3 ) ≤ 1 3 \begin{equation} Prob(X\ge 3)\le\frac{\mathrm{E}(X)}{3}\rightarrow Prob(X\ge 3)\le\frac{1}{3}\end{equation} Prob(X≥3)≤3E(X)→Prob(X≥3)≤31

p 3 + p 4 + p 5 ≤ 1 3 \begin{equation} p_3+p_4+p_5\le\frac{1}{3}\end{equation} p3+p4+p5≤31

2.3 Markov不等式公式 举例:

假设Andrew在平时工作一个星期中平均下来一个星期会犯 4 次错,也就是期望

E

(

X

)

=

4

\mathrm{E}(X)=4

E(X)=4,那么我们想知道如果Andrew在平时工作一个星期中会犯 10 次以上的错的概率多少?转换到数学公式如下:

E

(

X

)

=

4

,

P

r

o

b

(

X

>

10

)

≤

E

(

X

)

10

→

P

r

o

b

(

X

>

10

)

≤

40

%

\begin{equation} \mathrm{E}(X)=4, Prob(X>10)\le \frac{\mathrm{E}(X)}{10}\rightarrow Prob(X>10)\le40\% \end{equation}

E(X)=4,Prob(X>10)≤10E(X)→Prob(X>10)≤40%

- 也就是说Andrew 在平时一个星期中犯错10次以上的概率不会超过 40 % 40\% 40%

2.4 Chebyshev不等式公式概述:

如果随机变量X的期望

μ

\mu

μ,方差

σ

\sigma

σ存在,则对于任意

ϵ

>

0

\epsilon >0

ϵ>0,有如下公式:

P

(

∣

X

−

μ

∣

≥

ϵ

)

≤

σ

2

ϵ

2

\begin{equation} P{(|X-\mu|\ge \epsilon)}\le \frac{\sigma^2}{\epsilon^2} \end{equation}

P(∣X−μ∣≥ϵ)≤ϵ2σ2

2.5 Chebyshev不等式公式证明:

我们已经证明了马尔科夫不等式表示如下:

P

(

Y

≥

a

)

≤

E

(

Y

)

a

\begin{equation} P(Y\ge a)\le \frac{\mathrm{E}(Y)}{a} \end{equation}

P(Y≥a)≤aE(Y)

- 这里我们令

Y

=

(

X

−

μ

)

2

,

a

=

ϵ

2

Y=(X-\mu)^2,a=\epsilon^2

Y=(X−μ)2,a=ϵ2代入到公式中:

P ( ( X − μ ) 2 ≥ ϵ 2 ) ≤ E ( ( X − μ ) 2 ) ϵ 2 \begin{equation} P((X-\mu)^2\ge \epsilon^2)\le \frac{\mathrm{E}((X-\mu)^2)}{\epsilon^2} \end{equation} P((X−μ)2≥ϵ2)≤ϵ2E((X−μ)2) - 我们可以发现 P ( ( X − μ ) 2 ≥ ϵ 2 ) P((X-\mu)^2\ge \epsilon^2) P((X−μ)2≥ϵ2)等效于 P ( ∣ X − μ ∣ ≥ ϵ ) P(|X-\mu|\ge \epsilon) P(∣X−μ∣≥ϵ), σ 2 = E ( ( X − μ ) 2 ) \sigma^2=\mathrm{E}((X-\mu)^2) σ2=E((X−μ)2)

- 整理上述公式可得切尔雪夫不等式结果:

P ( ∣ X − μ ∣ ≥ ϵ ) ≤ σ 2 ϵ 2 \begin{equation} P(|X-\mu|\ge \epsilon)\le \frac{\sigma^2}{\epsilon^2} \end{equation} P(∣X−μ∣≥ϵ)≤ϵ2σ2

3. 协方差矩阵

设

Ω

\Omega

Ω为样本空间,P是定义在

Ω

\Omega

Ω的事件族

Σ

\Sigma

Σ上的概率,换句话来说,

Ω

,

Σ

,

P

\Omega,\Sigma,P

Ω,Σ,P是个概率空间;若X与Y定义在

Ω

\Omega

Ω上两个实数随机变量,期望分别为:

E

(

X

)

=

∫

Ω

X

d

P

=

μ

;

E

(

Y

)

=

∫

Ω

Y

d

P

=

v

;

\begin{equation} \mathrm{E}(X)=\int_{\Omega}X\mathrm{d}P=\mu;\mathrm{E}(Y)=\int_{\Omega}Y\mathrm{d}P=v; \end{equation}

E(X)=∫ΩXdP=μ;E(Y)=∫ΩYdP=v;

- 则两者间的协方差定义为:

c o v ( X , Y ) = E [ ( X − μ ) ( Y − v ) ] \begin{equation} \mathrm{cov}(X,Y)=\mathrm{E}[(X-\mu)(Y-v)] \end{equation} cov(X,Y)=E[(X−μ)(Y−v)]

3.1 举例

[感觉老师举的例子不好]

假设我们有两个硬币,X,Y 正反的概率均为0.5,那么概率矩阵为:

- 当两个硬币单独扔下去时,概率矩阵如下:

| Sample | x 1 = 正 x_1=正 x1=正 | x 2 = 反 x_2=反 x2=反 |

|---|---|---|

| y 1 = 正 y_1=正 y1=正 | 1 4 \frac{1}{4} 41 | 1 4 \frac{1}{4} 41 |

| y 2 = 反 y_2=反 y2=反 | 1 4 \frac{1}{4} 41 | 1 4 \frac{1}{4} 41 |

- 当两个硬币粘贴在一起扔下去时,概率矩阵如下:

| Sample | x 1 = 正 x_1=正 x1=正 | x 2 = 反 x_2=反 x2=反 |

|---|---|---|

| y 1 = 正 y_1=正 y1=正 | 1 2 \frac{1}{2} 21 | 0 0 0 |

| y 2 = 反 y_2=反 y2=反 | 0 0 0 | 1 2 \frac{1}{2} 21 |

- 当三个硬币单独扔下去时,两个硬币用平面表示,三个硬币用立方体表示

P H H H = 1 8 \begin{equation} P_{HHH}=\frac{1}{8} \end{equation} PHHH=81

3.2 Python 代码

C O V ( X , Y ) = 0.14516142787498987 \mathrm{COV}(X,Y)= 0.14516142787498987 COV(X,Y)=0.14516142787498987

import numpy as np

import matplotlib.pyplot as plt

# Generate some data

x = np.random.rand(100)

y = 2 * x + np.random.normal(0, 0.1, 100) # y is roughly 2 times x with some noise

# Calculate the covariance matrix

cov_matrix = np.cov(x, y)

# Extract the covariance value

cov_xy = cov_matrix[0, 1]

print(f"Covariance between x and y: {cov_xy}")

# Plotting the data

plt.scatter(x, y)

plt.title('Scatter plot of x and y')

plt.xlabel('x')

plt.ylabel('y')

plt.show()